涓涓不塞,是为江河;源源不断,是为奋斗;生生不息,是为中国。——人民日报

Hive入门

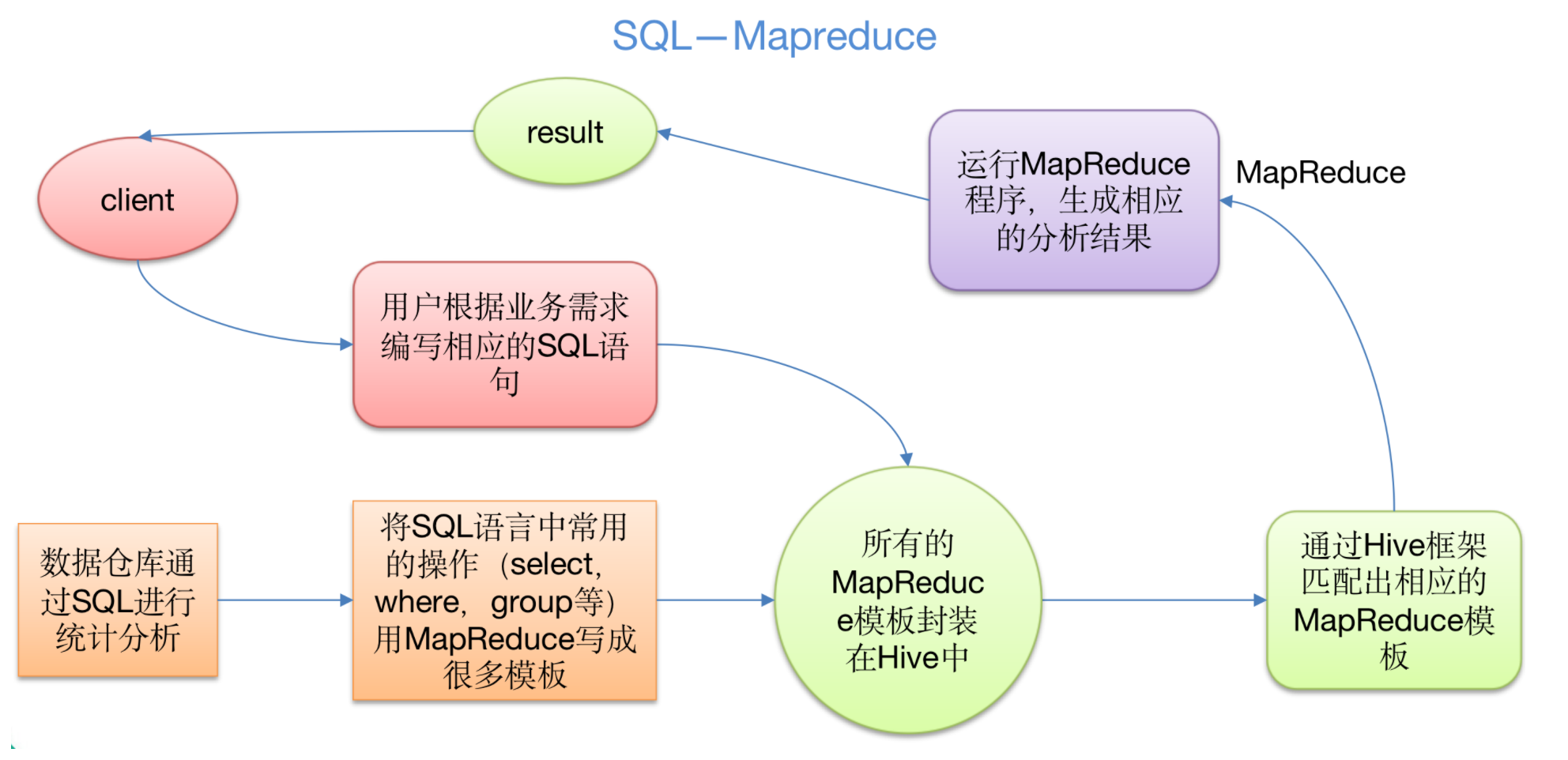

做数据分析用的,因为Hive里面不存数据. hive底层是MapReduce

什么是Hive

Hive:由Facebook开源用于解决海量结构化日志的数据统计。

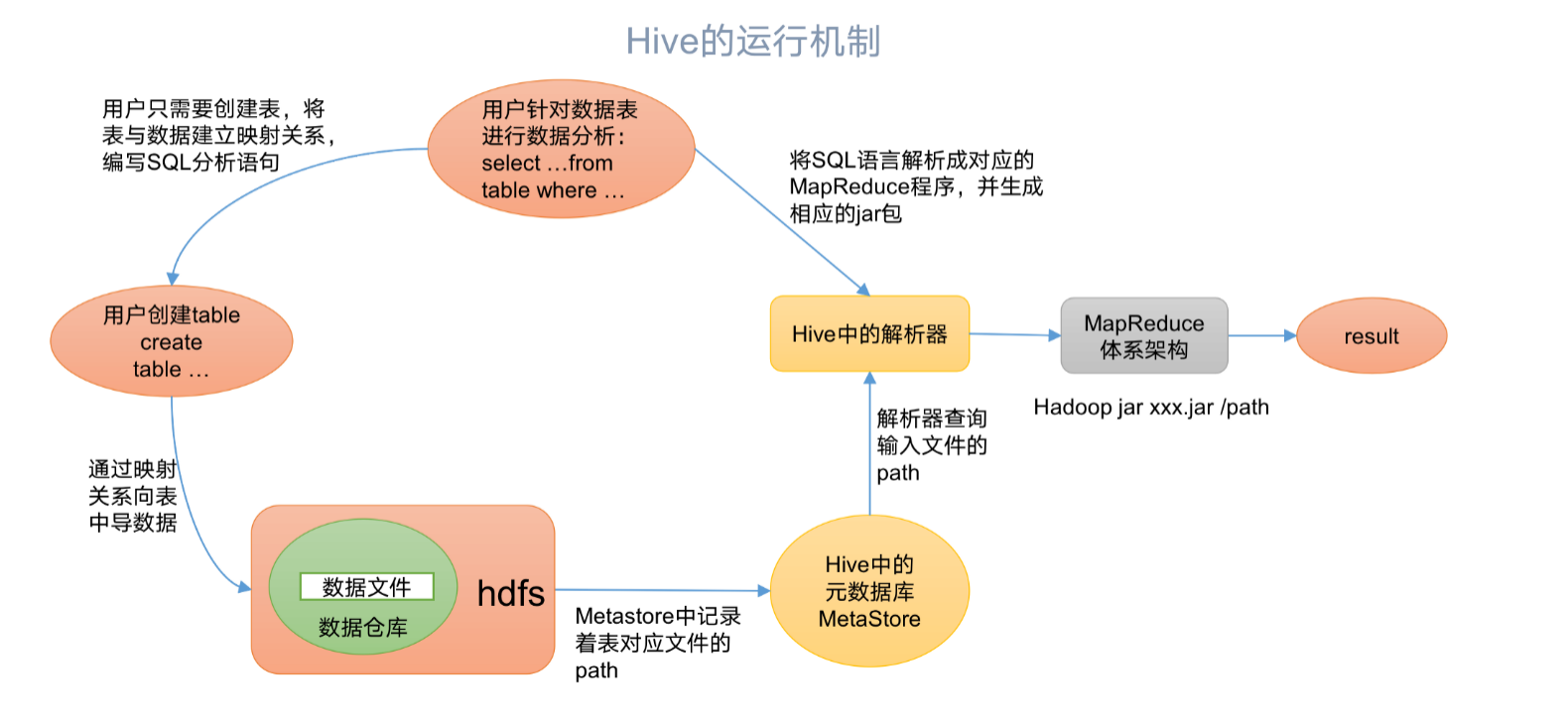

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类SQL查询功能。

本质是:将HQL转化成MapReduce程序

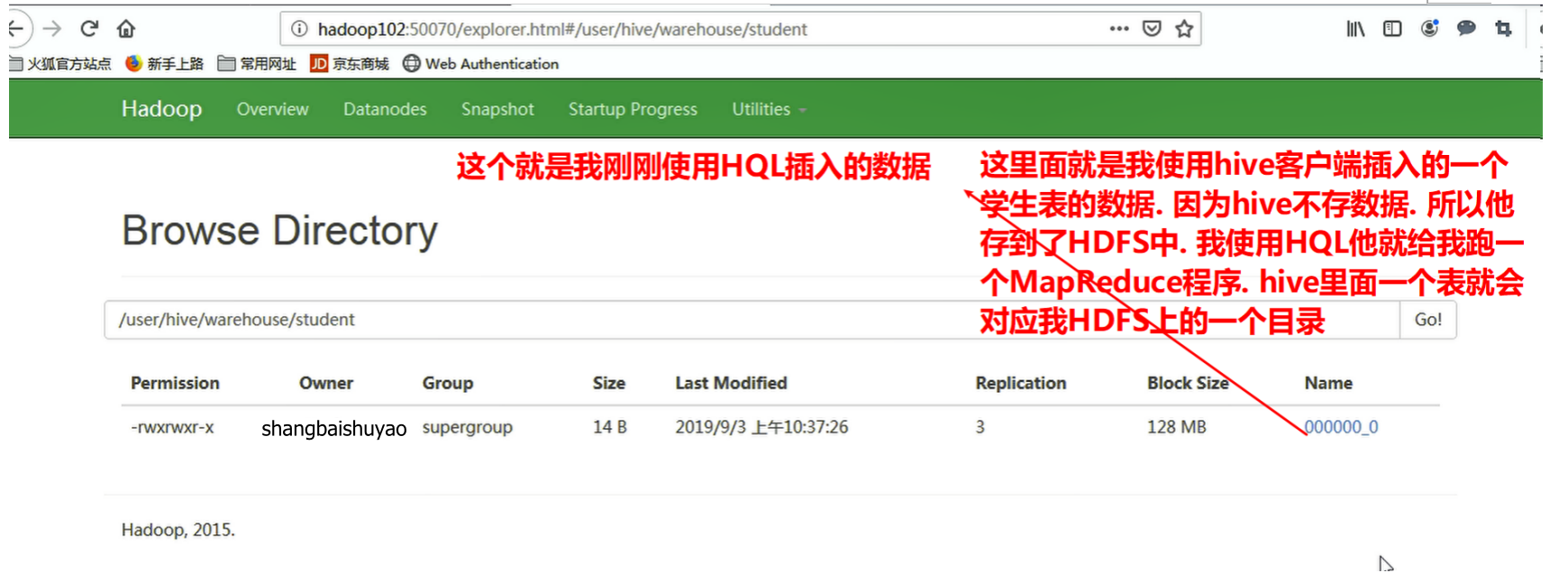

1)Hive处理的数据存储在HDFS

2)Hive分析数据底层的实现是MapReduce

3)执行程序运行在Yarn上

Hive的优缺点

优点

1 | 1)操作接口采用类SQL语法,提供快速开发的能力(简单、容易上手)。 |

缺点

1.Hive的HQL表达能力有限

1 | (1)迭代式算法无法表达(就是原始数据经过运算得到一个数据结果传给下一个在计算以此类推.这就是迭代) |

2.Hive的效率比较低(以为他通过HQL自动匹配模板,所以模板不能随便修改)

1 | (1)Hive自动生成的MapReduce作业,通常情况下不够自主化 |

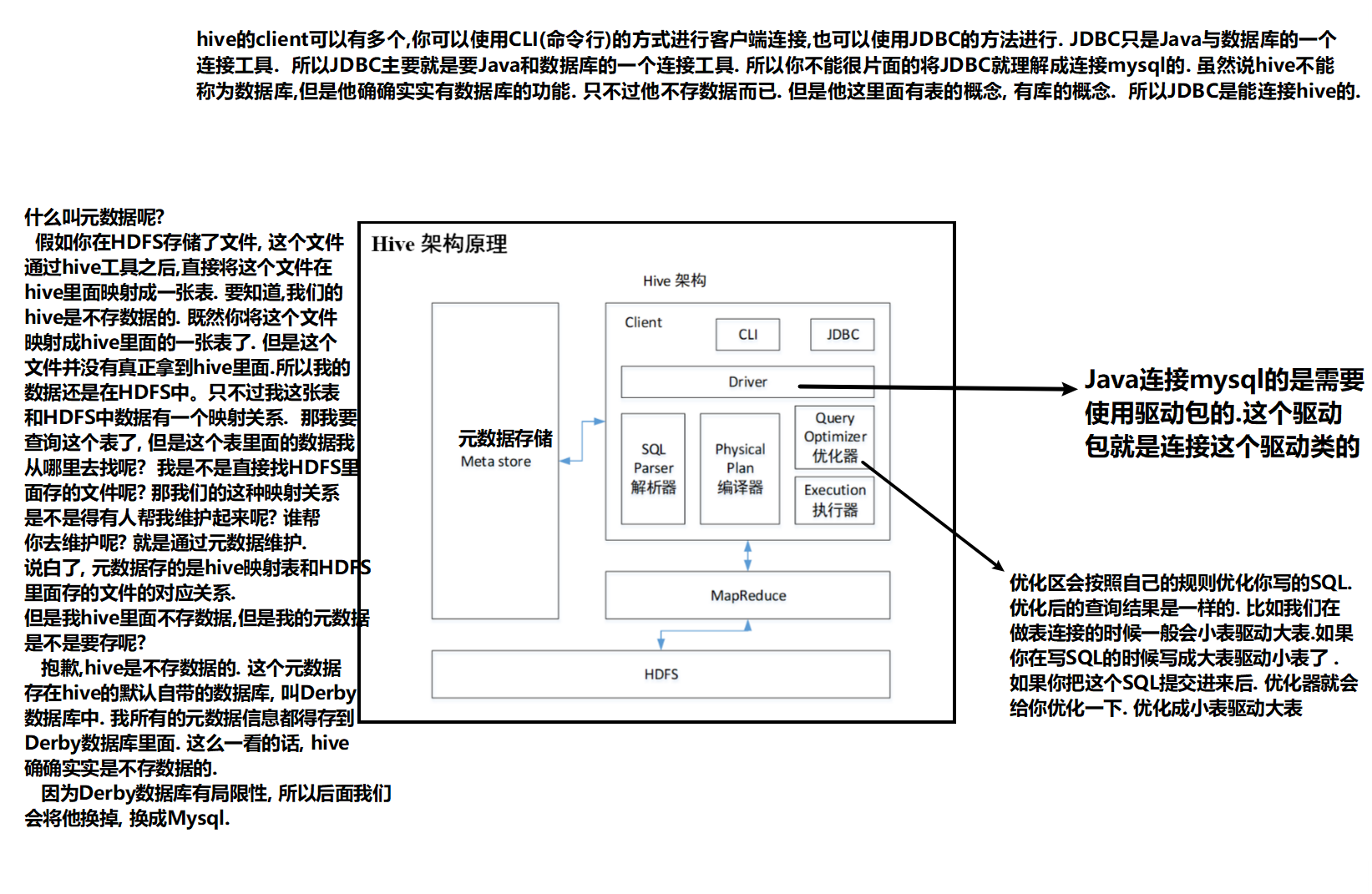

Hive架构原理

1.用户接口:Client

1 | CLI(hive shell)、JDBC/ODBC(java访问hive)、WEBUI(浏览器访问hive) |

2.元数据:Metastore

1 | 元数据包括:表名、表所属的数据库(默认是default)、表的拥有者、列/分区字段、表的类型(是否是外部表)、表的数据所在目录等; |

3.Hadoop

1 | 使用HDFS进行存储,使用MapReduce进行计算。 |

4.驱动器:Driver

1 | (1)解析器(SQL Parser):将SQL字符串转换成抽象语法树AST,这一步一般都用第三方工具库完成,比如antlr;对AST进行语法分析,比如表是否存在、字段是否存在、SQL语义是否有误。 |

Hive通过给用户提供的一系列交互接口,接收到用户的指令(SQL),使用自己的Driver,结合元数据(MetaStore),将这些指令翻译成MapReduce,提交到Hadoop中执行,最后,将执行返回的结果输出到用户交互接口。

Hive和数据库比较

由于 Hive 采用了类似SQL 的查询语言 HQL(Hive Query Language),因此很容易将 Hive 理解为数据库。其实从结构上来看,Hive 和数据库除了拥有类似的查询语言,再无类似之处。本文将从多个方面来阐述 Hive 和数据库的差异。数据库可以用在 Online 的应用中,但是Hive 是为数据仓库而设计的,清楚这一点,有助于从应用角度理解 Hive 的特性。

数据存储位置

Hive 是建立在 Hadoop 之上的,所有 Hive 的数据都是存储在 HDFS 中的。而数据库则可以将数据保存在块设备或者本地文件系统中

查询语言

由于SQL被广泛的应用在数据仓库中,因此,专门针对Hive的特性设计了类SQL的查询语言HQL。熟悉SQL开发的开发者可以很方便的使用Hive进行开发。

数据更新

由于Hive是针对数据仓库应用设计的,而数据仓库的内容是读多写少的。因此,Hive中不建议对数据的改写,所有的数据都是在加载的时候确定好的。而数据库中的数据通常是需要经常进行修改的,因此可以使用 INSERT INTO … VALUES 添加数据,使用 UPDATE … SET修改数据。

索引

Hive在加载数据的过程中不会对数据进行任何处理,甚至不会对数据进行扫描,因此也没有对数据中的某些Key建立索引。Hive要访问数据中满足条件的特定值时,需要暴力扫描整个数据,因此访问延迟较高。由于 MapReduce 的引入, Hive 可以并行访问数据,因此即使没有索引,对于大数据量的访问,Hive 仍然可以体现出优势。数据库中,通常会针对一个或者几个列建立索引,因此对于少量的特定条件的数据的访问,数据库可以有很高的效率,较低的延迟。由于数据的访问延迟较高,决定了 Hive 不适合在线数据查询。

执行

Hive中大多数查询的执行是通过 Hadoop 提供的 MapReduce 来实现的。而数据库通常有自己的执行引擎。

执行延迟

Hive 在查询数据的时候,由于没有索引,需要扫描整个表,因此延迟较高。另外一个导致 Hive 执行延迟高的因素是 MapReduce框架。由于MapReduce 本身具有较高的延迟,因此在利用MapReduce 执行Hive查询时,也会有较高的延迟。相对的,数据库的执行延迟较低。当然,这个低是有条件的,即数据规模较小,当数据规模大到超过数据库的处理能力的时候,Hive的并行计算显然能体现出优势。

可扩展性

由于Hive是建立在Hadoop之上的,因此Hive的可扩展性是和Hadoop的可扩展性是一致的(世界上最大的Hadoop 集群在 Yahoo!,2009年的规模在4000 台节点左右)。而数据库由于 ACID 语义的严格限制,扩展行非常有限。目前最先进的并行数据库 Oracle 在理论上的扩展能力也只有100台左右。

数据规模

由于Hive建立在集群上并可以利用MapReduce进行并行计算,因此可以支持很大规模的数据;对应的,数据库可以支持的数据规模较小。

Hive安装

Hive安装地址

1.Hive官网地址

http://hive.apache.org/

2.文档查看地址

https://cwiki.apache.org/confluence/display/Hive/GettingStarted

3.下载地址

http://archive.apache.org/dist/hive/

4.github地址

https://github.com/apache/hive

Hive安装部署

1.Hive安装及配置

(1)把apache-hive-1.2.1-bin.tar.gz上传到linux的/opt/software目录下

(2)解压apache-hive-1.2.1-bin.tar.gz到/opt/module/目录下面

1 | [shangbaishuyao@hadoop102 software]$ tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /opt/module/ |

(3)修改apache-hive-1.2.1-bin.tar.gz的名称为hive

1 | [shangbaishuyao@hadoop102 module]$ mv apache-hive-1.2.1-bin/ hive |

(4)修改/opt/module/hive/conf目录下的hive-env.sh.template名称为hive-env.sh

1 | [shangbaishuyao@hadoop102 conf]$ mv hive-env.sh.template hive-env.sh |

(5)配置hive-env.sh文件

(a)配置HADOOP_HOME路径

1 | export HADOOP_HOME=/opt/module/hadoop-2.7.2 |

(b)配置HIVE_CONF_DIR路径(hive配置文件的路径)

1 | export HIVE_CONF_DIR=/opt/module/hive/conf |

2.Hadoop集群配置

(1)必须启动hdfs和yarn

1 | [shangbaishuyao@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh |

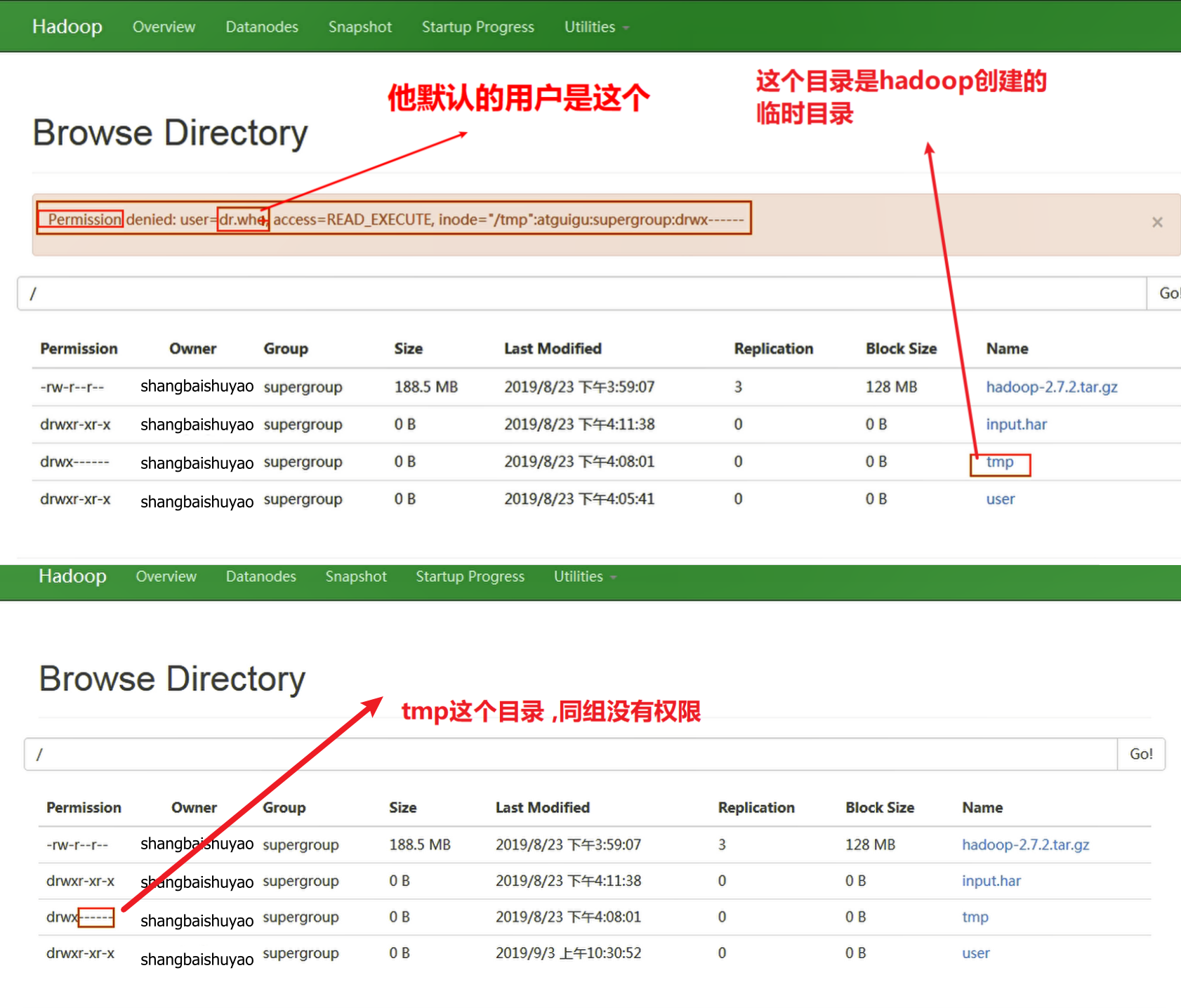

(2)在HDFS上创建/tmp和/user/hive/warehouse两个目录并修改他们的同组权限可写

1 | [shangbaishuyao@hadoop102 hadoop-2.7.2]$ bin/hadoop fs -mkdir /tmp |

Hive基本操作

(1)启动hive

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive |

(2)查看数据库

1 | hive> show databases; |

(3)打开默认数据库

1 | hive> use default; |

(4)显示default数据库中的表

1 | hive> show tables; |

(5)创建一张表

1 | hive> create table student(id int, name string); |

(6)显示数据库中有几张表

1 | hive> show tables; |

(7)查看表的结构

1 | hive> desc student; |

(8)向表中插入数据

1 | hive> insert into student values(1000,"ss"); |

(9)查询表中数据

1 | hive> select * from student; |

(10)退出hive

1 | hive> quit; |

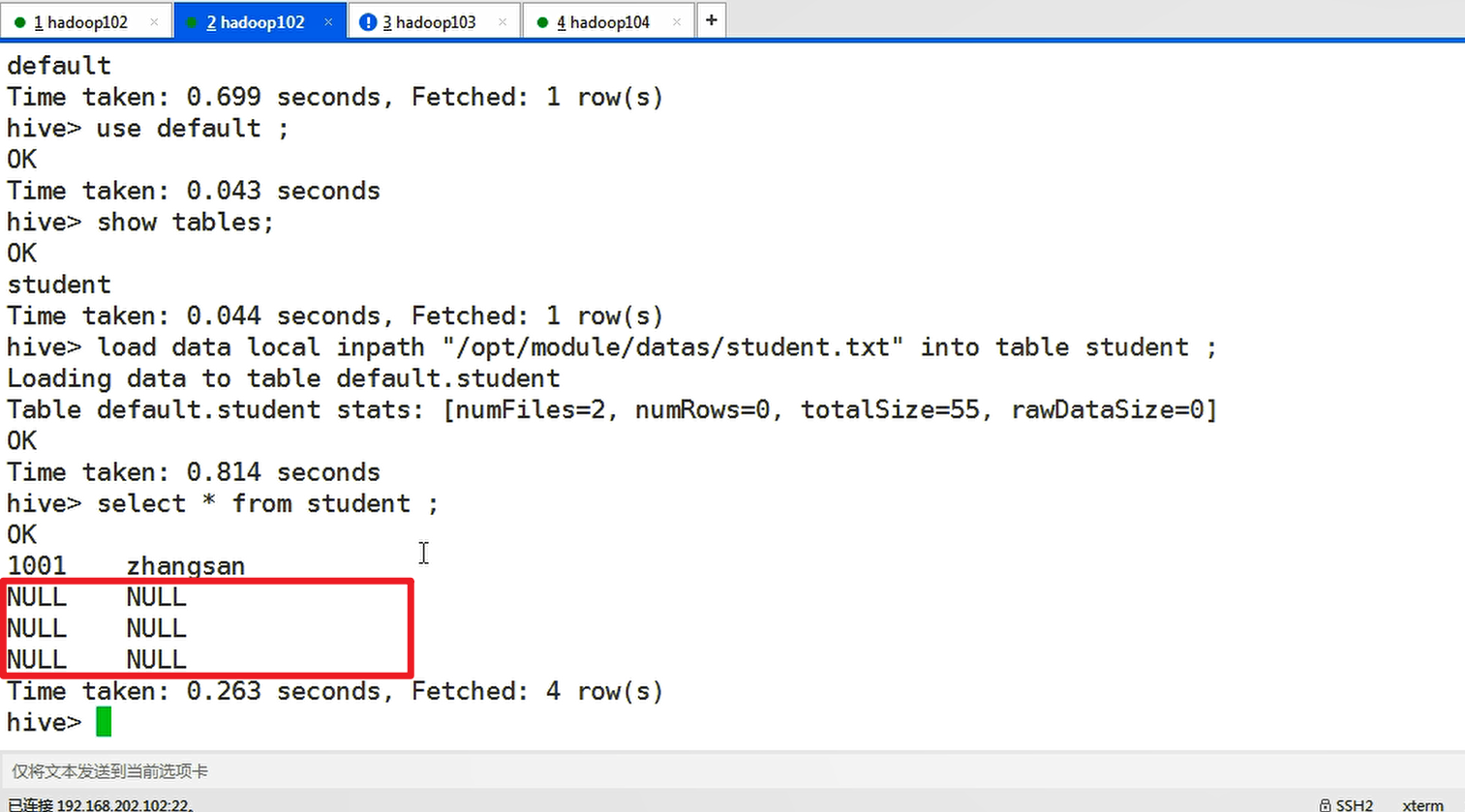

将本地文件导入Hive案例

需求

将本地/opt/module/datas/student.txt这个目录下的数据导入到hive的student(id int, name string)表中。

1.数据准备

在/opt/module/datas这个目录下准备数据

(1)在/opt/module/目录下创建datas

1 | [shangbaishuyao@hadoop102 module]$ mkdir datas |

(2)在/opt/module/datas/目录下创建student.txt文件并添加数据

1 | [shangbaishuyao@hadoop102 datas]$ touch student.txt |

注意以tab键间隔。

2.Hive实际操作

(1)启动hive

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive |

(2)显示数据库

1 | hive> show databases; |

(3)使用default数据库

1 | hive> use default; |

(4)显示default数据库中的表

1 | hive> show tables; |

(5)删除已创建的student表

1 | hive> drop table student; |

(6)创建student表, 并声明文件分隔符’\t’

1 | hive> create table student(id int, name string) ROW FORMAT DELIMITED FIELDS TERMINATED |

本地文件导入hive案例

(7)加载/opt/module/datas/student.txt 文件到student数据库表中。

1 | hive> load data local inpath '/opt/module/datas/student.txt' into table student; |

将文件映射成student表

(8)Hive查询结果

1 | hive> select * from student; |

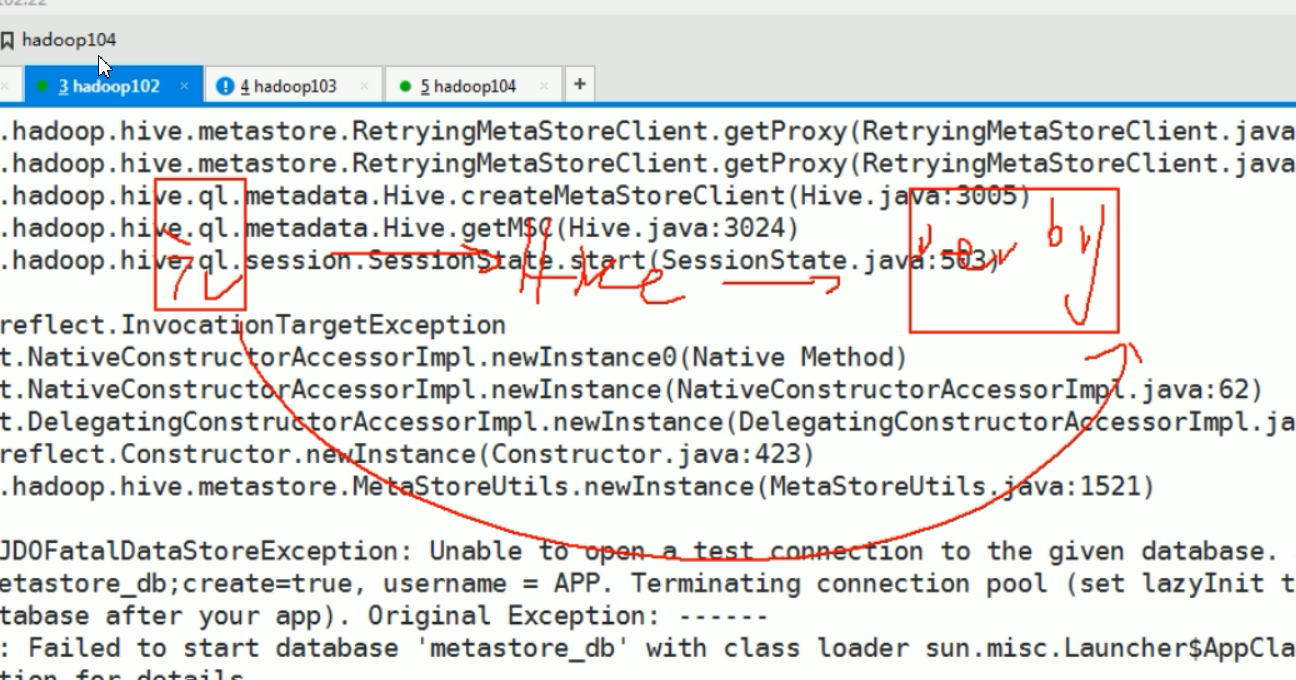

3.遇到的问题

再打开一个客户端窗口启动hive,会产生java.sql.SQLException异常。

所以不能同时打开多个hive连接,如何解决呢?就是不用Derby数据库,使用mysql

1 | Exception in thread "main" java.lang.RuntimeException: java.lang.RuntimeException: |

原因是,Metastore默认存储在自带的derby数据库中,推荐使用MySQL存储Metastore;

MySql安装

安装包准备

1.查看mysql是否安装,如果安装了,卸载mysql

(1)查看

1 | [root@hadoop102 桌面]# rpm -qa|grep mysql |

(2)卸载

1 | [shangbaishuyao@Hadoop102 mysql-libs]$ sudo rpm -e mysql-libs-5.1.73-7.el6.x86_64 删不掉,因为有依赖,所以加上--nodeps |

2.解压mysql-libs.zip文件到当前目录

1 | [root@hadoop102 software]# unzip mysql-libs.zip |

3.进入到mysql-libs文件夹下

1 | [root@hadoop102 mysql-libs]# ll |

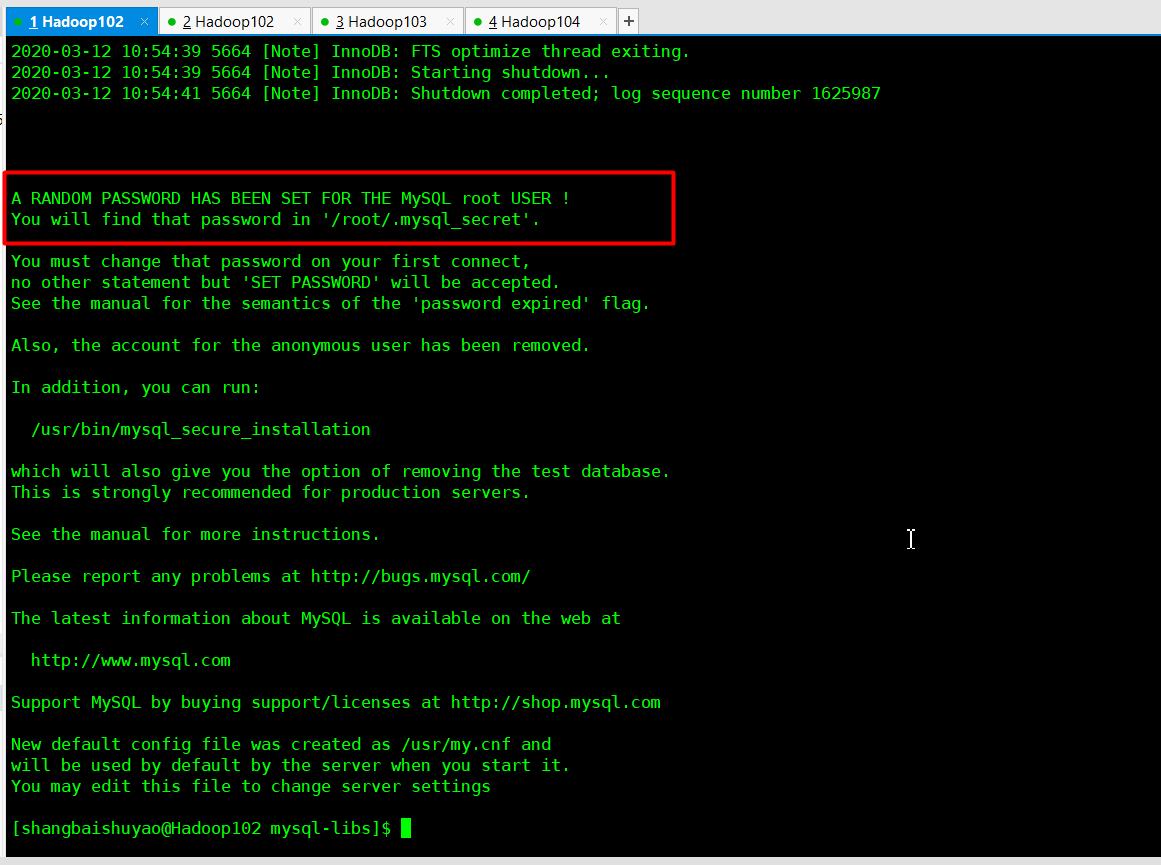

安装MySql服务器

1.安装mysql服务端

1 | [shangbaishuyao@Hadoop102 mysql-libs]$ rpm -ivh MySQL-server-5.6.24-1.el6.x86_64.rpm |

2.查看产生的随机密码

所以必须修改随机密码:

1 | [root@hadoop102 mysql-libs]# cat /root/.mysql_secret |

如果无法进入则:切换用户来进入

3.查看mysql状态

1 | [root@hadoop102 mysql-libs]# service mysql status |

启动mysql和查看状态:

1 | [shangbaishuyao@Hadoop102 ~]$ su - root |

4.启动mysql

1 | [root@hadoop102 mysql-libs]# service mysql start |

安装MySql客户端

1.安装mysql客户端

1 | [root@hadoop102 mysql-libs]# rpm -ivh MySQL-client-5.6.24-1.el6.x86_64.rpm |

2.链接mysql

1 | [root@hadoop102 mysql-libs]# mysql -uroot -pOEXaQuS8IWkG19Xs |

3.修改密码

1 | SET PASSWORD=PASSWORD('000000'); |

4.退出mysql

1 | exit |

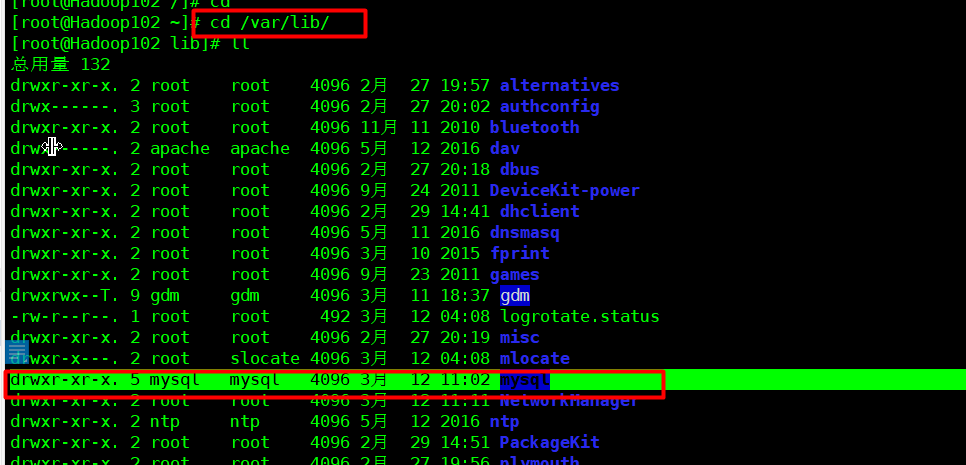

删除mysql上不干净怎么办?一定要把这个删了

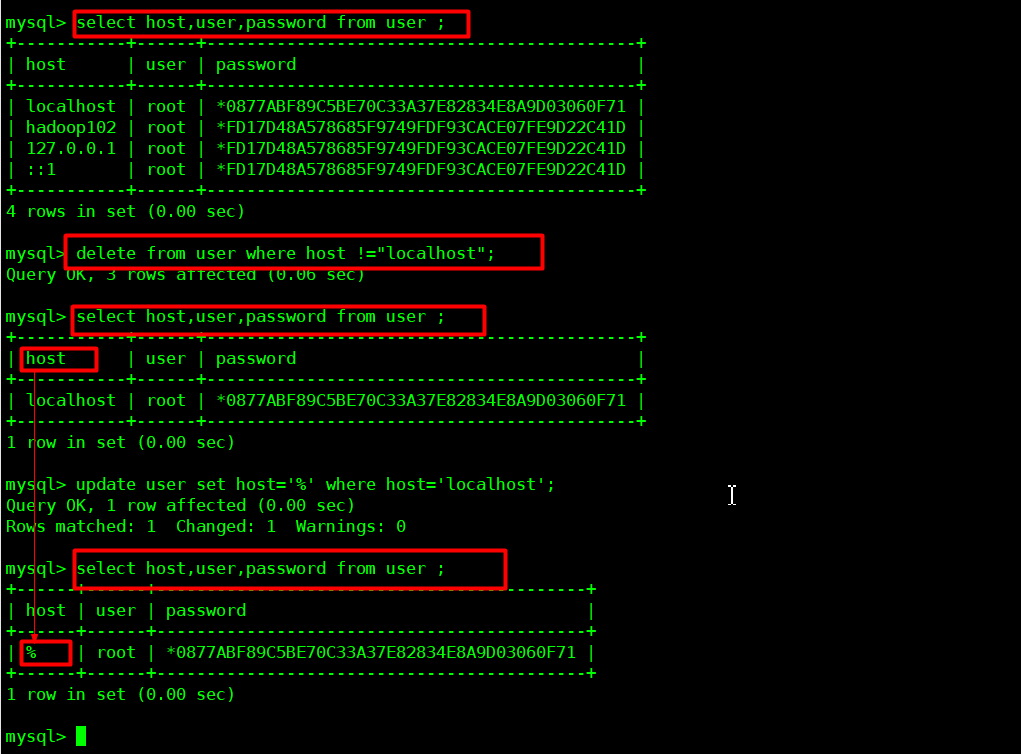

MySql中user表中主机配置

1 | [root@Hadoop102 mysql-libs]# mysql -uroot -pshangbaishuyao |

如图可以看到:任意机器都可以访问了

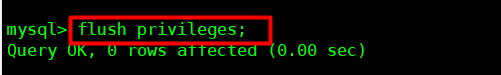

一定要记得刷新权限:

配置只要是root用户+密码,在任何主机上都能登录MySQL数据库。

1.进入mysql

1 | [root@hadoop102 mysql-libs]# mysql -uroot -pshangbaishuyao |

2.显示数据库

1 | mysql>show databases; |

3.使用mysql数据库

1 | mysql>use mysql; |

4.展示mysql数据库中的所有表

1 | mysql>show tables; |

5.展示user表的结构

1 | mysql>desc user; |

6.查询user表

1 | mysql>select User, Host, Password from user; |

7.修改user表,把Host表内容修改为%

1 | mysql>update user set host='%' where host='localhost'; |

8.删除root用户的其他host

1 | mysql>delete from user where Host='hadoop10'; |

9.刷新

1 | mysql>flush privileges; |

10.退出

1 | mysql>quit; |

Hive元数据配置到MySql

驱动拷贝

1.在/opt/software/mysql-libs目录下解压mysql-connector-java-5.1.27.tar.gz驱动包

1 | [root@hadoop102 mysql-libs]# tar -zxvf mysql-connector-java-5.1.27.tar.gz |

2.拷贝/opt/software/mysql-libs/mysql-connector-java-5.1.27目录下的mysql-connector-java-5.1.27-bin.jar到/opt/module/hive/lib/

1 | [root@hadoop102 mysql-connector-java-5.1.27]# cp mysql-connector-java-5.1.27-bin.jar /opt/module/hive/lib/ |

2.5.2 配置Metastore到MySql

1.在/opt/module/hive/conf目录下创建一个hive-site.xml

1 | [shangbaishuyao@hadoop102 conf]$ touch hive-site.xml |

2.根据官方文档配置参数,拷贝数据到hive-site.xml文件中

https://cwiki.apache.org/confluence/display/Hive/AdminManual+Metastore+Administration

1 | <?xml version="1.0"?> |

3.配置完毕后,如果启动hive异常,可以重新启动虚拟机。(重启后,别忘了启动hadoop集群)

多窗口启动Hive测试

1.先启动MySQL

1 | [shangbaishuyao@hadoop102 mysql-libs]$ mysql -uroot -p000000 |

2.再次打开多个窗口,分别启动hive

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive |

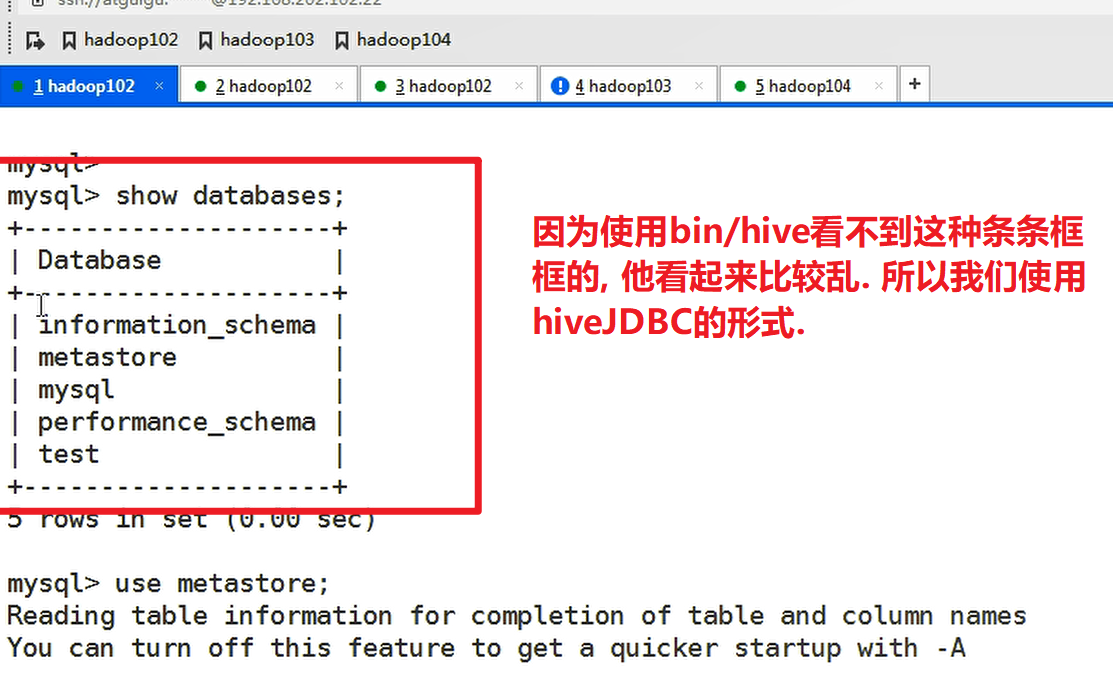

3.启动hive后,回到MySQL窗口查看数据库,显示增加了metastore数据库

1 | mysql> show databases; |

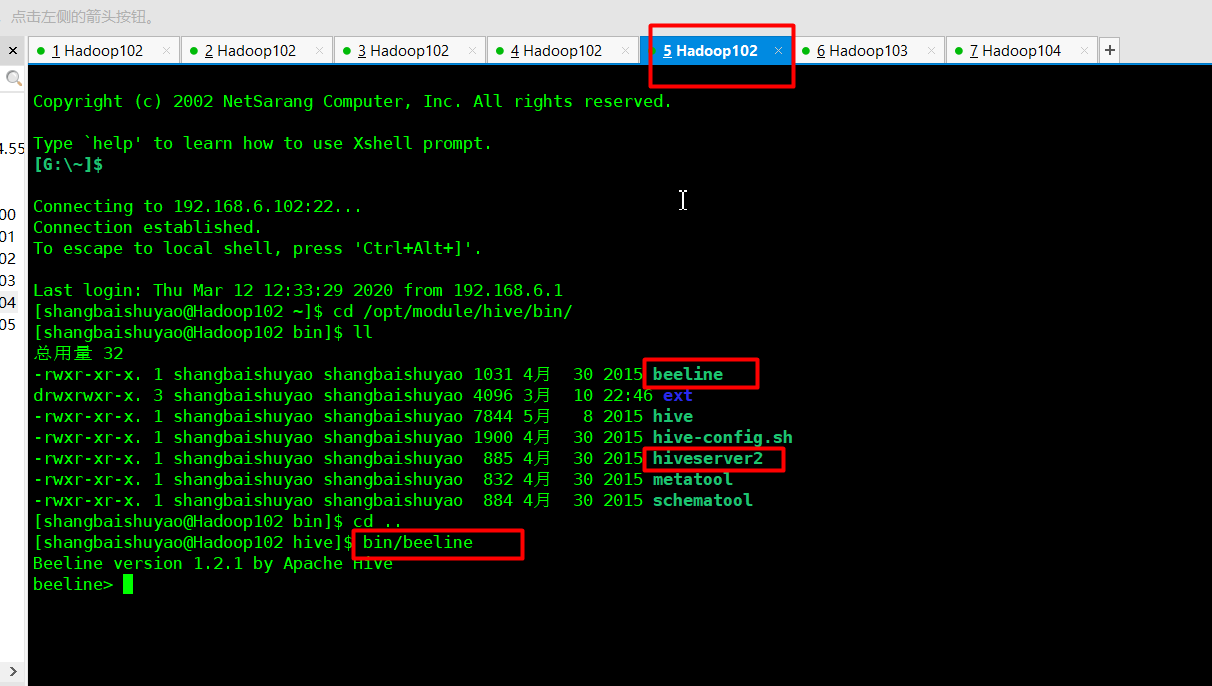

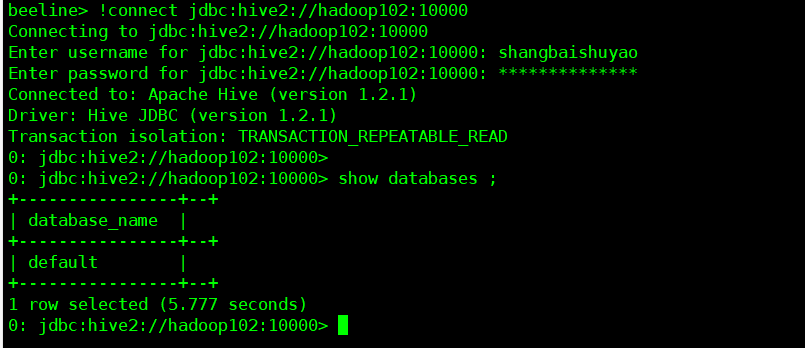

HiveJDBC访问

为什么使用hiveJDBC形式连接呢?

准备1:

准备2:

启动hiveserver2服务,CDH中不用启动这个

1 | [shangbaishuyao@hadoop102 hive]$ bin/hiveserver2 |

启动beeline,在CDH中任何目录下直接beeline

1 | [shangbaishuyao@hadoop102 hive]$ bin/beeline |

上白书妖补充完成图片:

Hive账号密码:

Hive常用交互命令

他不是连到hive客户端里面用的,他是连接到

正常情况下,我们要连接到hive客户端里面才能操作.如下:

1.“-e”不进入hive的交互窗口执行sql语句

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive -e "select id from student;" |

2.“-f”执行脚本中sql语句

(1)在/opt/module/datas目录下创建hivef.sql文件

1 | [shangbaishuyao@hadoop102 datas]$ touch hivef.sql |

文件中写入正确的sql语句

select *from student;

(2)执行文件中的sql语句

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive -f /opt/module/datas/hivef.sql |

(3)执行文件中的sql语句并将结果写入文件中

1 | [shangbaishuyao@hadoop102 hive]$ bin/hive -f /opt/module/datas/hivef.sql > /opt/module/datas/hive_result.txt |

Hive其他命令操作

1.退出hive窗口:

1 | exit; |

在新版的hive中没区别了,在以前的版本是有的:

exit:先隐性提交数据,再退出;

quit:不提交数据,退出;

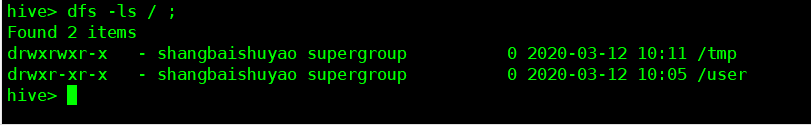

2.在hive cli命令窗口中如何查看hdfs文件系统

1 | hive(default)>dfs -ls /; |

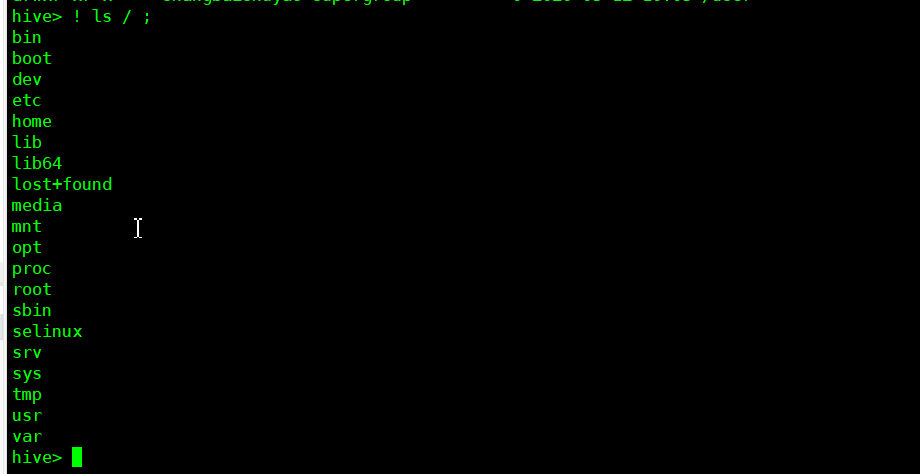

3.在hive cli命令窗口中如何查看本地文件系统

1 | hive(default)>! ls /opt/module/datas; |

4.查看在hive中输入的所有历史命令

(1)进入到当前用户的根目录/root或/home/shangbaishuyao

(2)查看. hivehistory文件

1 | [shangbaishuyao@hadoop102 ~]$ cat .hivehistory |

Hive常见属性配置

Hive数据仓库位置配置

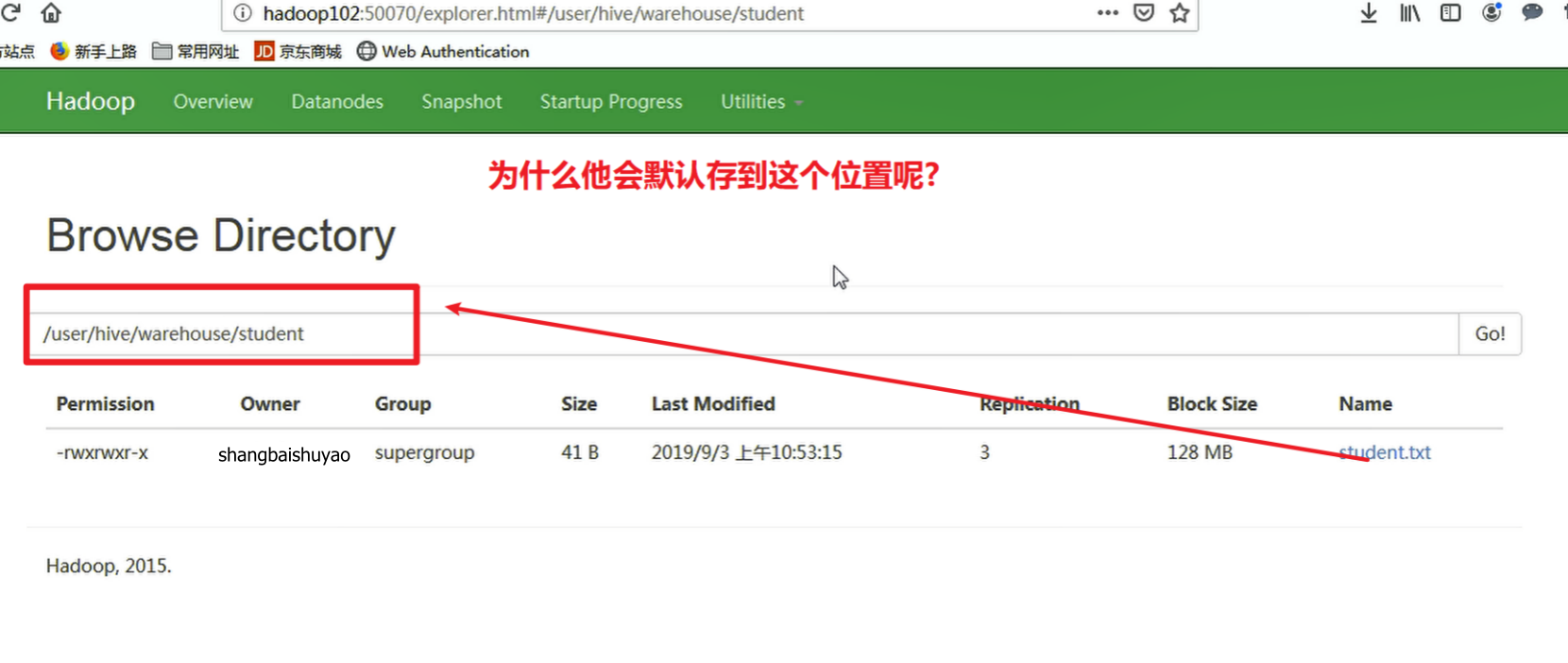

因为他就是我们默认default这个库的最原始位置.

1)Default数据仓库的最原始位置是在hdfs上的:/user/hive/warehouse路径下。

2)在仓库目录下,没有对默认的数据库default创建文件夹。如果某张表属于default数据库,直接在数据仓库目录下创建一个文件夹。

3)修改default数据仓库原始位置(将hive-default.xml.template如下配置信息拷贝到hive-site.xml文件中)。

1 | <property> |

配置同组用户有执行权限

1 | bin/hdfs dfs -chmod g+w /user/hive/warehouse |

查询后信息显示配置

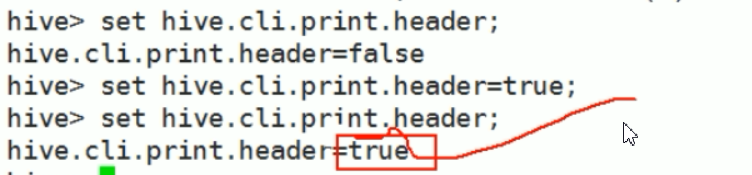

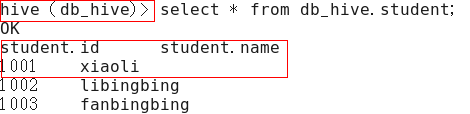

1)在hive-site.xml文件中添加如下配置信息,就可以实现显示当前数据库,以及查询表的头信息配置。

1 | <property> |

上白书妖补充效果图:

这种方式只是在当时有用,退出重进之后就没用了,所以我们要进行上面配置

文件的配置

2)重新启动hive,对比配置前后差异。

(1)配置前,如图所示

(2)配置后,如图所示

Hive运行日志信息配置

1.Hive的log默认存放在/tmp/shangbaishuyao/hive.log目录下(当前用户名下)

因为放在tmp目录下,他是会定期清除的,所以要修改

2.修改hive的log存放日志到/opt/module/hive/logs

(1)修改/opt/module/hive/conf/hive-log4j.properties.template文件名称为

hive-log4j.properties

1 | [shangbaishuyao@hadoop102 conf]$ pwd |

(2)在hive-log4j.properties文件中修改log存放位置

hive.log.dir=/opt/module/hive/logs

参数配置方式

Hive的底层是hadoop,所以就逃不开hadoop四个默认的配置文件以及四个自定义文件如:core-site.xml等,所以说我们在启动hive的时候,这八个文件肯定会去加载的,这个我们hadoop的时候学过,所以我们一下配置就没加入,但是如果你hadoop都没有配置的话,你得先从hadoop开始配置

1.查看当前所有的配置信息

hive>set;

参数的配置三种方式

三种方式中: 修改xml文件是永久生效,其他只是当前生效

(1)第一种:配置文件方式

默认配置文件:hive-default.xml

用户自定义配置文件:hive-site.xml

注意:用户自定义配置会覆盖默认配置。另外,Hive也会读入Hadoop的配置,因为Hive是作为Hadoop的客户端启动的,Hive的配置会覆盖Hadoop的配置。配置文件的设定对本机启动的所有Hive进程都有效。

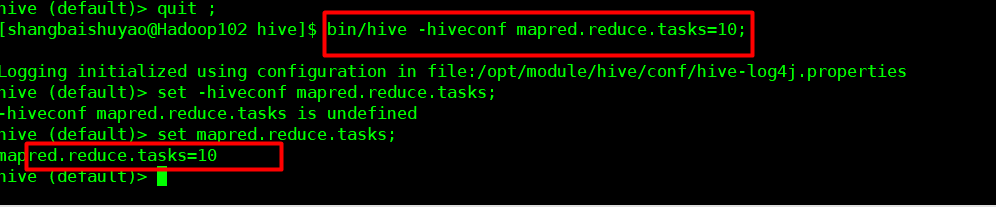

(2)第二种:命令行参数方式

启动Hive时,可以在命令行添加-hiveconf param=value来设定参数。

例如:

1 | [shangbaishuyao@hadoop103 hive]$ bin/hive -hiveconf mapred.reduce.tasks=10; |

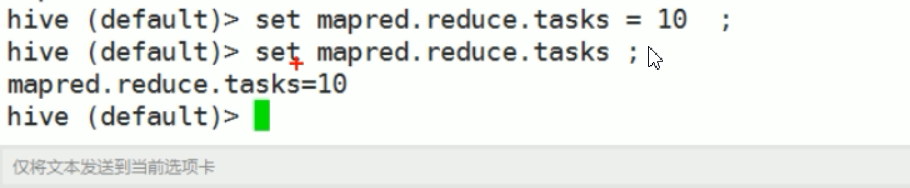

设置参数

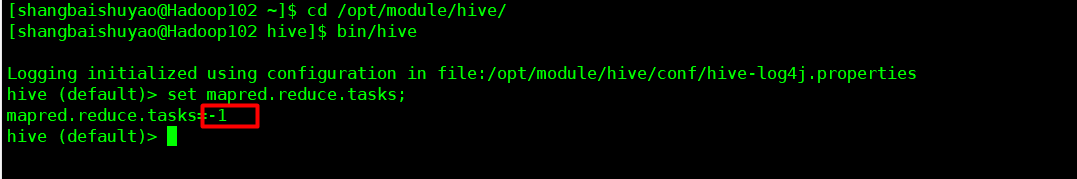

注意: 如果只是set mapred.reduce.tasks;就是查看

set mapred.reduce.tasks = 10; 这是设置成10个

注意:仅对本次hive启动有效

查看参数设置:

1 | hive (default)> set mapred.reduce.tasks; |

shangbaishuayo补充:默认是-1

(3)第三种:参数声明方式

可以在HQL中使用SET关键字设定参数

例如:

1 | hive (default)> set mapred.reduce.tasks=100; |

注意:仅对本次hive启动有效。

查看参数设置

1 | hive (default)> set mapred.reduce.tasks; |

上述三种设定方式的优先级依次递增。即配置文件<命令行参数<参数声明。注意某些系统级的参数,例如log4j相关的设定,必须用前两种方式设定,因为那些参数的读取在会话建立以前已经完成了。配置文件的方式是永久有效的

Hive数据类型

基本数据类型

| Hive数据类型 | Java数据类型 | 长度 | 例子 |

|---|---|---|---|

| TINYINT (tinyint) | byte | 1byte有符号整数 | 20 |

| SMALINT (smalint) | short | 2byte有符号整数 | 20 |

| INT (int) | int | 4byte有符号整数 | 20 |

| BIGINT (bigint) | long | 8byte有符号整数 | 20 |

| BOOLEAN (boolean) | boolean | 布尔类型,true或者false | TRUE FALSE |

| FLOAT (float) | float | 单精度浮点数 | 3.14159 |

| DOUBLE (double) | double | 双精度浮点数 | 3.14159 |

| STRING (string) | string | 字符系列。可以指定字符集。可以使用单引号或者双引号。 | ‘now is the time’ “for all good men” |

| TIMESTAMP (timestamp) | 时间类型 | ||

| BINARY (binary) | 字节数组 |

对于Hive的String类型相当于数据库的varchar类型,该类型是一个可变的字符串,不过它不能声明其中最多能存储多少个字符,理论上它可以存储2GB的字符数。

集合数据类型

| 数据类型 | 描述 | 语法示例 |

|---|---|---|

| STRUCT | 和c语言中的struct类似,都可以通过“点”符号访问元素内容。例如,如果某个列的数据类型是STRUCT{first STRING, last STRING},那么第1个元素可以通过字段.first来引用。 | struct() |

| MAP | MAP是一组键-值对元组集合,使用数组表示法可以访问数据。例如,如果某个列的数据类型是MAP,其中键->值对是’first’->’John’和’last’->’Doe’,那么可以通过字段名[‘last’]获取最后一个元素 | map() |

| ARRAY | 数组是一组具有相同类型和名称的变量的集合。这些变量称为数组的元素,每个数组元素都有一个编号,编号从零开始。例如,数组值为[‘John’, ‘Doe’],那么第2个元素可以通过数组名[1]进行引用。 | Array() |

Hive有三种复杂数据类型ARRAY、MAP 和 STRUCT。ARRAY和MAP与Java中的Array和Map类似,而STRUCT与C语言中的Struct类似,它封装了一个命名字段集合,复杂数据类型允许任意层次的嵌套。

案例实操

1)假设某表有如下一行,我们用JSON格式来表示其数据结构。在Hive下访问的格式为

1 | { |

2)基于上述数据结构,我们在Hive里创建对应的表,并导入数据。

创建本地测试文件test.txt 在../datas/test.txt

1 | songsong,bingbing_lili,xiao song:18_xiaoxiao song:19,hui long guan_beijing |

注意:MAP,STRUCT和ARRAY里的元素间关系都可以用同一个字符表示,这里用“_”。

3)Hive上创建测试表test

_

1 | create table test( |

字段解释:

row format delimited fields terminated by ‘,’ – 列分隔符

collection items terminated by ‘_’ –MAP STRUCT 和 ARRAY 的分隔符(数据分割符号)

map keys terminated by ‘:’ – MAP中的key与value的分隔符

lines terminated by ‘\n’; – 行分隔符

4)导入文本数据到测试表

1 | hive (default)> load data local inpath ‘/opt/module/datas/test.txt’into table test |

5)访问三种集合列里的数据,以下分别是ARRAY,MAP,STRUCT的访问方式

1 | hive (default)> select friends[1],children['xiao song'],address.city from test |

类型转化

Hive的原子数据类型是可以进行隐式转换的,类似于Java的类型转换,例如某表达式使用INT类型,TINYINT会自动转换为INT类型,但是Hive不会进行反向转化,例如,某表达式使用TINYINT类型,INT不会自动转换为TINYINT类型,它会返回错误,除非使用CAST操作。

1.隐式类型转换规则如下

(1)任何整数类型都可以隐式地转换为一个范围更广的类型,如TINYINT可以转换成INT,INT可以转换成BIGINT。

(2)所有整数类型、FLOAT和STRING类型都可以隐式地转换成DOUBLE。

(3)TINYINT、SMALLINT、INT都可以转换为FLOAT。

(4)BOOLEAN类型不可以转换为任何其它的类型。

2.可以使用CAST操作显示进行数据类型转换

例如CAST(‘1’ AS INT)将把字符串’1’ 转换成整数1;如果强制类型转换失败,如执行CAST(‘X’ AS INT),表达式返回空值 NULL。

- 本文作者: xubatian

- 本文链接: http://xubatian.cn/hive简介(一)/

- 版权声明: 本博客所有文章除特别声明外均为原创,采用 CC BY 4.0 CN协议 许可协议。转载请注明出处:https://www.xubatian.cn/

故人的博客

故人的博客

IT周的博客

IT周的博客

大胖胖的笔记

大胖胖的笔记

常瑞的部落落

常瑞的部落落

Fortune博客

Fortune博客

星空下的YZY

星空下的YZY

BOBL技术博客

BOBL技术博客